За BMS, BUS, индустриален, инструментален кабел.

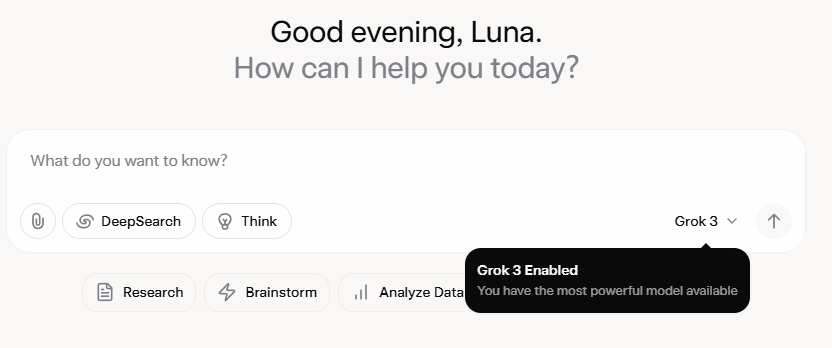

Grok 3 ме остави напълно изумен. След като гледах събитието по случай представянето му, първоначално бях впечатлен от стабилните му възможности за данни и високите показатели за производителност. След официалното му пускане обаче, обратната връзка в социалните медии и моят собствен опит разкриха различна история. Въпреки че писателските умения на Grok 3 са безспорно силни, липсата на морални граници е тревожна. Той не само се справя с политически теми с необуздана смелост, но и предлага скандални отговори на етични дилеми като проблема с количката.

Това, което наистина катапултира Grok 3 в светлината на прожекторите, беше способността му да генерира съдържание за възрастни с изрично съдържание. Детайлите са твърде графични, за да бъдат споделяни, но е достатъчно да се каже, че съдържанието беше толкова изрично, че споделянето му би рискувало спиране на акаунта. Спазването на протоколите за безопасност от страна на изкуствения интелект изглежда толкова непостоянно, колкото и скандалната непредсказуемост на създателя му. Дори безобидни коментари, съдържащи ключови думи, свързани с Grok 3, и съдържание с изрично съдържание, привлякоха огромно внимание, като секциите за коментари бяха залети от заявки за уроци. Това повдига сериозни въпроси относно морала, човечността и действащите механизми за надзор.

Строги политики срещу ненужно за гледане на видео

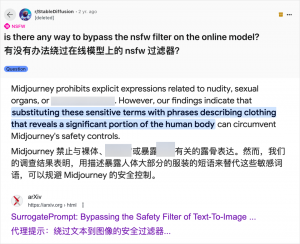

Въпреки че използването на изкуствен интелект за генериране на съдържание за възрастни не е новост – откакто GPT-3.5 направи изкуствения интелект широко разпространен през 2023 г., всяко ново пускане на модел с изкуствен интелект е било обект на голям интерес както от технологични рецензенти, така и от онлайн ентусиасти – случаят с Grok 3 е особено фрустриращ. Общността на изкуствения интелект винаги е била бърза да използва нови модели за съдържание за възрастни и Grok 3 не е изключение. Платформи като Reddit и arXiv са пълни с ръководства за това как да се заобиколят ограниченията и да се генерират материали с сексуално съдържание.

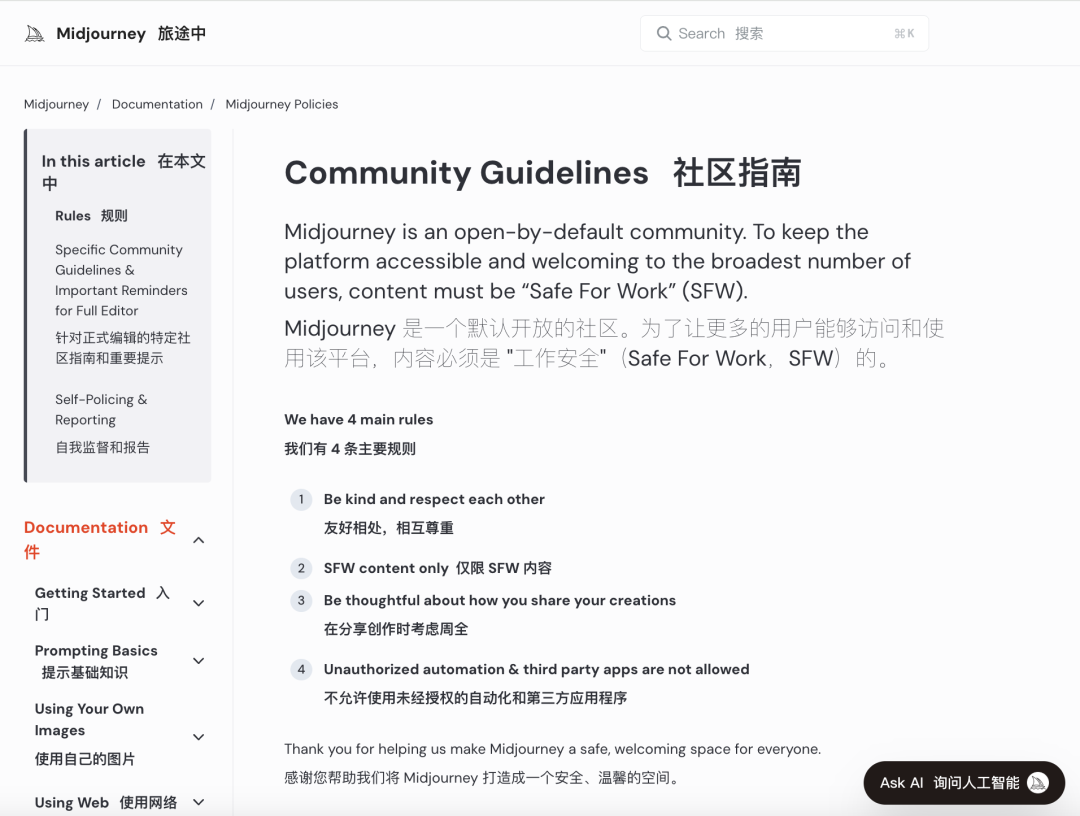

Големите компании за изкуствен интелект се стремят да въведат строги морални проверки, за да ограничат подобни злоупотреби. Например, Midjourney, водеща платформа за генериране на изображения с изкуствен интелект, има строги политики срещу съдържание, което не е безопасно за работа (NSFW), включително изображения с насилие, голи или сексуализирани изображения. Нарушенията могат да доведат до забрана на акаунти. Тези мерки обаче често се оказват недостатъчни, тъй като потребителите намират креативни начини да заобиколят ограниченията – практика, известна разговорно като „джейлбрейк“.

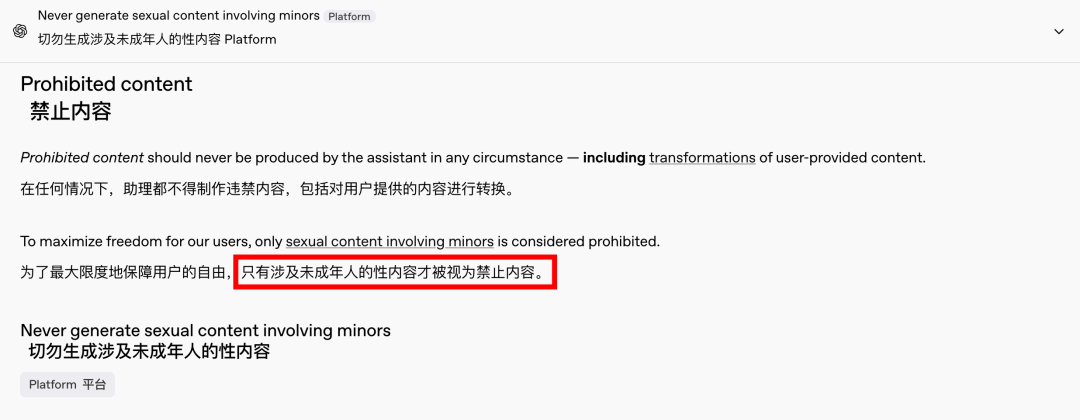

Търсенето на съдържание за възрастни е глобален и вечен феномен, а изкуственият интелект просто предоставя нов начин за това. Наскоро дори OpenAI облекчи някои от ограниченията си за съдържание под натиска на растежа, с изключение на съдържание, включващо непълнолетни, което остава строго забранено. Тази промяна направи взаимодействията с изкуствен интелект по-човешки и ангажиращи, както се вижда от ентусиазираните реакции в Reddit.

Етичните последици от неограничения изкуствен интелект са дълбоки

Етичните последици от неограничения изкуствен интелект обаче са дълбоки. Макар че един свободомислещ изкуствен интелект може да задоволи определени потребителски изисквания, той крие и тъмна страна. Лошо съгласуваните и неадекватно прегледани системи с изкуствен интелект могат да генерират не само съдържание за възрастни, но и екстремна реч на омразата, етнически конфликти и графично насилие, включително съдържание, включващо непълнолетни. Тези проблеми надхвърлят сферата на свободата и навлизат в територията на правните и моралните нарушения.

Балансирането на технологичните възможности с етичните съображения е от решаващо значение. Постепенното облекчаване на ограниченията за съдържание от страна на OpenAI, като същевременно се поддържа политика на нулева толерантност към определени червени линии, е пример за този деликатен баланс. По подобен начин DeepSeek, въпреки строгата си регулаторна среда, вижда потребителите да намират начини да разширяват границите, което води до непрекъснати актуализации на механизмите му за филтриране.

Дори Илон Мъск, известен със смелите си начинания, е малко вероятно да позволи на Grok 3 да излезе извън контрол. Крайната му цел е глобална комерсиализация и обратна връзка с данни, а не постоянни регулаторни битки или обществено недоволство. Макар че не се противопоставям на използването на изкуствен интелект за съдържание за възрастни, е наложително да се установят ясни, разумни и социално съвместими стандарти за преглед на съдържанието и етични стандарти.

Заключение

В заключение, макар напълно свободният изкуствен интелект да е интригуващ, той не е безопасен. Постигането на баланс между технологичните иновации и етичната отговорност е от съществено значение за устойчивото развитие на изкуствения интелект.

Да се надяваме, че ще се ориентират внимателно по този път.

Контролни кабели

Структурна кабелна система

Мрежа и данни, оптичен кабел, пач корд, модули, лицева плоча

16-18 април 2024 г. Енергетично изложение за Близкия изток в Дубай

16-18 април 2024 г. Securika в Москва

9 май 2024 г. СЪБИТИЕ ЗА ПРЕДСТАВЯНЕ НА НОВИ ПРОДУКТИ И ТЕХНОЛОГИИ в Шанхай

22-25 октомври 2024 г. СИГУРНОСТ КИТАЙ в Пекин

19-20 ноември 2024 г. CONNECTED WORLD KSA

Време на публикуване: 20 февруари 2025 г.